Indexación

La indexación es un proceso imprescindible por el que tiene que pasar cualquier url antes de aparecer en Google. Básicamente es un procedimiento por el que los robots de Google entran en nuestra web, la analizan y la incorporan a su índice. A partir de ese momento, Google empezará a mostrar la url a los usuarios cuando considere que esta responde a sus necesidades.

En este post vamos a analizar en detalle todos los aspectos relacionados con la indexación y los posibles problemas que pueden impedir que un dominio se indexe. Posteriormente pasaremos a dar respuesta a algunas de las dudas frecuentes que suelen trasladarnos nuestros clientes sobre este tema.

¿Qué es la indexación?

La indexación es el proceso por el que tiene que pasar cualquier url antes de aparecer en los resultados de Google. Cuando creamos una url está empezará a formar parte de nuestro dominio para después ser rastreada por los bots de este buscador.

Estos, la analizarán e interpretarán; asignándole una valoración y decidiendo cómo y por qué palabra clave aparecerá (o no) en sus resultados de búsqueda.

Posibles problemas de indexación

Si has recibido un mensaje en el que se te indica que tu dominio no ha sido indexado principalmente puede deberse a varios motivos:

- Contenidos irrelevantes o duplicidades.

- Problemas de HTML.

- Bloqueos a Google no controlados.

- Google todavía no lo ha detectado.

- Está indexado con un dominio diferente.

- Problemas con la IP del servidor.

Hay dos posibles causas para tener un problema de indexación, o bien el SEO no hay hecho su trabajo o es el programador el que no lo ha hecho.

Contenido irrelevante o duplicidades

El problema de indexación más común es que Google considere que tu contenido no es relevante, lo que puede pasar por muchos motivos. Imagina una web tipo ecommerce llena de filtros cuyos resultados muestran una y otra vez los mismos productos, evidentemente Google va a decidir tomar una sola URL como referencia para mostrar, descartando el resto.

Problemas de HTML

Hay etiquetas de HTML que bloquean el contenido a Google:

- Noindex, si tenemos esta etiqueta en una URL le estamos indicando directamente que no queremos que aparezca en los resultados de Google.

- Canonical: si tenemos una URL con un canonical hacia otra URL es posible que Google indexe la que tiene esta etiqueta pero también hemos visto casos en los que cuando Google tiene que decidir qué URL quiere desindexar esta suele estar en primera fila.

- Redireccionamientos 3XX: así es como se define cuando quieres que una URL dirija a otra URL de forma automática. En estos casos Google (con el tiempo) suele quitar estas URLs cuando ya no las considera relavantes.

Bloqueos a Google no controlados

Otro fallo muy común es tener mal configurado el robots.txt y de esta forma impedir que Google pueda acceder a las URLs, imágenes o cualquier otro elemento; posteriormente hablaremos de este archivo.

Google todavía no ha detectado tu sitio

En el caso de que se trate de una web que se ha creado recientemente o tenga pocos enlaces desde otras webs puede ser que Google todavía no haya tenido tiempo a rastrearlo e incluirlo a su índice.

Esta situación es fácil de solucionar ya que Google pone herramientas a nuestra disposición para informarle de la existencia de nuestro dominio y solicitar que lo indexe.

Para asegurarte de que Google reconozca todas las URLs de tu web lo más recomendable es crear y enviar tu sitemap para que pueda detectar e indexar URLs que quizá no descubriría mediante un rastreo normal.

Tu sitio está indexado con un dominio diferente

Por otro lado, también puede darse el caso de que tu sitio esté indexando con un dominio diferente. Esto se debe a que el formato de las URLs no siempre incluye el subdominio www o que esté alojado en una subcarpeta si está en un sitio de alojamiento gratuito.

Muchos sitios web ofrecen el mismo contenido independientemente de si se incluye el www como si no pero para Google serían dos URLs diferentes que pueden ofrecer contenidos distintos.

Problemas con la IP del servidor.

En algunos casos nos hemos encontrado que si alguna web con la que se comparte IP en el servidor es denunciada a Google por spam este mete en una lista negra y excluye dicha IP de sus resultados de búsquedas. Cuando esto pasa, lo mejor es cambiar de IP (comprobar que no te den otra con el mismo problema) o cambiar el proveedor del servicio de hosting.

¿Cuál es la tendencia?

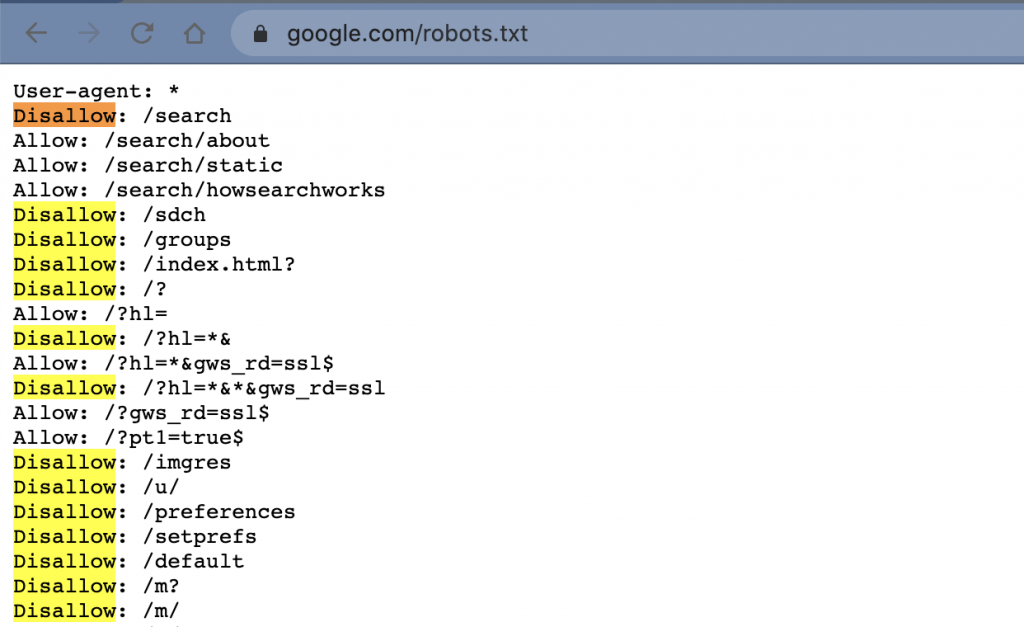

Los SEOs tenemos la costumbre de poner etiquetas de HTML a Google para que indexe un dominio pero, realmente esto no debería de ser así. Si no tenemos ninguna etiqueta de HTML que indique lo contrario, Google puede y debe de indexar dicha URL. De hecho, si vemos algunas URLs de Google podemos ver qué es lo que él hace con muchos de sus proyectos.

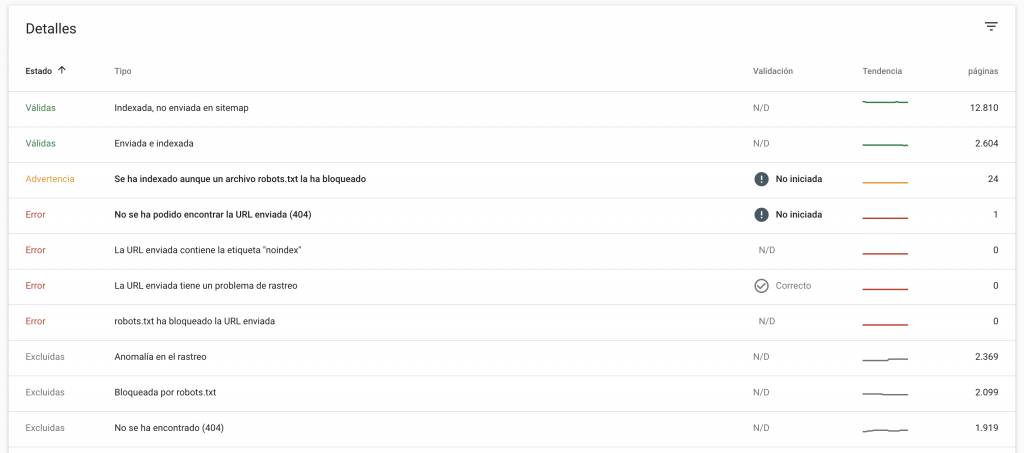

Informe de cobertura de indexación

La mejor forma de saber qué páginas de tu dominio se han incluido en el índice de Google y si se ha detectado algún problema es solicitar un informe de cobertura de indexación en Search Console. En él se incluye el estado de todas las urls que Google ha visitado o ha intentado visitar dentro de tu dominio.

En su página de resumen podrás ver todos estos resultados con las urls agrupadas por estado, distinguiendo entre error, advertencia, excluidas o válidas. Además, en los dos primeros casos podrás ver el motivo de este estado. Vamos a ver más detenidamente qué significa cada estado de la url:

- Error: La página no está indexada debido al error que se describa. Es un estado que deberías resolver cuanto antes.

- Advertencia: La página está indexada pero tiene algún problema que deberías tener en cuenta.

- Excluidas: La página no está indexada pero Google ha interpretado que esa es tu intención. Por ejemplo, si la has excluido de forma intencionada con una etiqueta no index.

- Válidas: La página está indexada y no tienen ningún problema.

Ejemplo de informe de cobertura de indexación

En este informe la verdad es que hay mucha información de valor para medir y mejorar la indexación de nuestras webs.

Dentro de todos los datos disponibles hay dos a los que prestar especial atención:

- Indexada, no enviada en sitemap: quiere decir que Google está rastreando (perdiendo el tiempo) en URLs que no tienes en el sitemap. Por lo cual, posiblemente no te interese que esto ocurra.

- Anomalía en el rastreo: quiere decir que hay algún problema que se ha de solucionar.

Tienes más información en este enlace.

Solicitar indexación a Google

En ocasiones nos interesará enviar puntualmente urls a Google para que las indexe rápidamente. Una forma de acelerar el proceso es solicitando su indexación.

Para ello, desde Search Console tendremos que introducir la url que nos interese en la herramienta de "inspección de urls". Después, escogemos la opción de "solicitar indexación".

Una vez que hayamos seleccionado esta opción, la herramienta probará en tiempo real que la url no tenga ningún problema de indexación claro. Si no hay problemas, la página se pondrá en la cola para indexarse. Mientas que si se detectan problemas se nos avisará para que intentemos corregirlos.

No todos los problemas están en nuestra web

A veces el fallo no está dentro de nuestra web sino que es debido a motivos externos. Una de las situaciones más llamativas fue la que sucedió el pasado abril de 2019 cuando Google perdió parte de su índice debido a un problema de implementación.

A medida que iba aplicando algunos cambios en su índice partes de su sistema se fueron rompiendo y como consecuencia una “pequeña” parte de sus datos se perdió. Pequeña para Google claro, lo que quiere decir que afectó a una gran cantidad de dominios que de repente vieron como parte de sus urls pasaron a estar desindexadas.

En mayo del año pasado también sucedió algo similar cuando Google estuvo varios días sin poder indexar páginas nuevas en su buscador provocando que los usuarios no pudiesen acceder a contenidos actualizados. Este hecho afectó especialmente a sitios de actualidad, el ABC por ejemplo se hizo eco de la situación con una noticia cuyo titular no deja lugar a dudas de lo sucedido: “Los dos días en los que Google dejó de indexar”.

Las consecuencias positivas que podemos sacar de estos incidentes es que Google ha optado por mejorar su estrategia de comunicación con el objetivo de mitigar la preocupación de los webmasters. A raíz del problema de los datos perdidos en abril de 2019 Google ha implantado tres puntos clave para comunicar cualquier problema de este tipo en el futuro:

- Explorar nuevas formas de compartir información dentro de Search Console de una forma más ágil.

- Publicar más rápidamente en la página de anomalías de datos de Search Console.

- Continuar tuiteando lo más rápido posible para tranquilizar a los webmasters.

Hay dos elementos que tenemos que tener siempre presentes

Hay dos elementos fundamentales para la indexación o desindexación, los sitemaps y los archivos robots.txt, ya que sirven para comunicar a Google qué queremos indexar y desindexar. Hay mucha más información que podríamos comentar sobre estos dos elementos y que se debería de estudiar.

Sitemaps

Los sitemaps son unos archivos en los que se ofrece información sobre todas las páginas, vídeos y archivos de un sitio web y cómo se relacionan entre ellos. Los buscadores como Google los leen al visitar cualquier web para rastrearla de una forma más eficaz.

Como norma general, si las URLs de tu web están bien enlazadas, Google podrá detectarlas todas sin problemas. Sin embargo, los sitemaps le ayudan a acelerar el proceso. Por eso, son siempre recomendable e imprescindibles en webs grandes o muy complejas.

Enviar tu sitemap a Google es imprescindible siempre que:

- Tengas un dominio muy grande, con más de 500 páginas.

- Cuentes con muchas páginas con contenido aisladas o una estructura de enlazado interno débil.

- Tu dominio sea nuevo y tenga pocos enlaces externos apuntando hacia él.

- Cuenten con una gran cantidad de rich media (vídeos e imágenes) o aparezcas en Google News.

Robots.txt

El robots.txt es un archivo dirigido a los bots de rastreo de los buscadores que les informa de las páginas o archivos a los que pueden solicitar -o no- acceso dentro de tu sitio web. Su principal utilidad es la de evitar que una web se sobrecargue por un envío masivo (y generalmente malicioso) de solicitudes de acceso.

En otras palabras, sirve para gestionar el tráfico de tu sitio web y para evitar que tu servidor se sobrecargue con solicitudes del rastreador de Google en páginas sin importancia o similares.

Es importante tener en cuenta que el robot.txt no se utiliza para ocultar una página web de los resultados de Google. De hecho, hay posibilidades de que sus bots de rastreo puedan llegar igualmente a ella si hay enlaces desde cualquier otra parte de la web y se acabe indexando. Si quieres que una url no aparezca en Google lo mejor es utilizar una etiqueta noindex.

Un uso muy interesante de este archivo es evitar que los archivos multimedia aparezcan en los resultados de búsqueda de Google. Del mismo modo también puedes bloquear los archivos de recursos como imágenes, secuencias de comandos o estilo que no sean importantes si crees que prescindir de ellos no afectará de forma importante a las páginas que se carguen sin ellos.

¿Debemos de tener todo el proyecto indexado?

La respuesta es categóricamente no. Sobre todo en proyectos donde tenemos un volumen muy alto de contenidos o un contenido similar o con una permanencia corta en la web.

Un buen ejemplo lo tenemos en el propio robots.txt de Google, con la sentencia "Disallow" se está bloqueando la indexación.

Debemos de tener siempre muy presente que es lo que realmente necesitamos posicionar y en que URLs para favorecer que Google acceda a dicha información. Sobre todo si son URLs con un contenido dinámico o que cambie de forma constante.

Otro elemento a tener muy en cuenta es la etiqueta "User-agent:". En los robots.txt, se usa para bloquear ciertos bots que consumen recursos del servidor.

¿Qué debemos y que no debemos de indexar?

Debemos de tener siempre indexadas todas las URLs que tienen un objetivo SEO y evitar la indexación de todo que no cumpla con la normativa de Google porque sea un contenido muy similar o bien sea un contenido que nos interese.

Imagina que tienes un ecommerce con 10 productos similares pero solo a uno de ellos le puedes sacar una mayor rentabilidad económica, puedes bloquear los productos menos rentables y dejar solo el que más te interesa.

Si utilizas un Wordpress por ejemplo es muy normal que tengas URLs del tipo /feed/ que también hacen perder el tiempo a Google en la indexación, normalmente son objeto de bloqueo.

En todos los dominios hay muchos elementos que se pueden bloquear, dependiendo de la estrategia de SEO.

Cuando tienes un proyecto nuevo

Cuando tienes un dominio nuevo hay varias cosas que hay que tener en cuenta. Google no va indexar todo un dominio solo porque lo lances a internet.

Con menos de 100 URLs

En estos casos la indexación no suele ser un problema y la recomendación es enviar todo el dominio a indexar y controlar que se hace correctamente desde Search Console enviado todo el sitemap.

Con menos de 500 URLs

Para dominios que tengan entre 100 y 500 URLs la recomendación cambia. Primero hay que enviar solo el sitemap de las páginas principales y cuando estas estén indexadas enviar el resto de URLs en otro sitemap.

Con más de 1000 URLs

Para dominios entre 500 y 1000 URLs la recomendación es la misma que la anterior, pero en este caso hay que intentar enviar cada semana un sitemap de unas 100 ó 200 URLs para ir controlando cómo y qué se indexa. De esta forma puedes descubrir en muchos casos qué es lo que le interesa a Google de tu dominio y que no. Así puedes evitar posibles problemas de indexación.

Cuando tienes muchas URLs es crucial saber cómo las interpreta Google y, si lo detectas, puedes evitar que se indexen mal desde el principio.

Con más de 10.000 URLs

Misma recomendación que en el caso de las 1000 URLs pero aquí el truco está en hacer sitemaps muy segmentados, separando URLs de imágenes, vídeos, recetas... Cuanto más se pueda dividir, mejor. También hay que tener en cuenta que va a ser mucho más fácil de analizar todo cuanto más dividido esté.

Nadie mejor para aprender a mejorar la indexación de grandes dominios que el robotos.txt de Amazon, fijaros cómo incluye los robots.

# Sitemap files Sitemap: https://www.amazon.es/sitemaps.2307ea63773dfee.SitemapIndex_0.xml.gz Sitemap: https://www.amazon.es/sitemaps.d449d7f825f081e.SitemapIndex_0.xml.gz Sitemap: https://www.amazon.es/sitemaps.e49bfbf08ac5517.SitemapIndex_0.xml.gz Sitemap: https://www.amazon.es/sitemaps.95918f5af3f77b0.SitemapIndex_0.xml.gz Sitemap: https://www.amazon.es/sitemaps.02b411f7e4baecc.SitemapIndex_0.xml.gz

Si os paráis a analizar como lo hace Amazon, veréis que se puede aprender muchísimo.

Recomendaciones finales sobre indexación

Hay elementos que se deben de tener para mejorar la indexación:

- Una visión estratégica de todo el proyecto: Las herramientas solo son herramientas y todo lo que has leído solo está basado en experiencias. Cada dominio es un mundo diferente y debe de ser tratado como tal.

- Una paciencia infinita: La indexación no algo tan simple como darle a un botón y que funcione o no, hay que ser paciente y estratégico.

- Herramientas eficientes: Puedes y debes de usar herramientas como Search Console para ver cómo va todo. Pero también debes de hacerte de herramientas como Screaming Frog Log File Analyser y trabajar muy ligado a tu departamento de programación y sistemas informáticos para analizar todos los datos.

- No eres el único cliente de Google: Google analiza millones de URLs nuevas todos los días, entiende que tú solo eres un número; no es algo personal.

Si tienes problemas de indexación y quieres que revisemos tu proyecto, solo tienes que contactar.